So durchbrechen Sie das SISO-Prinzip.

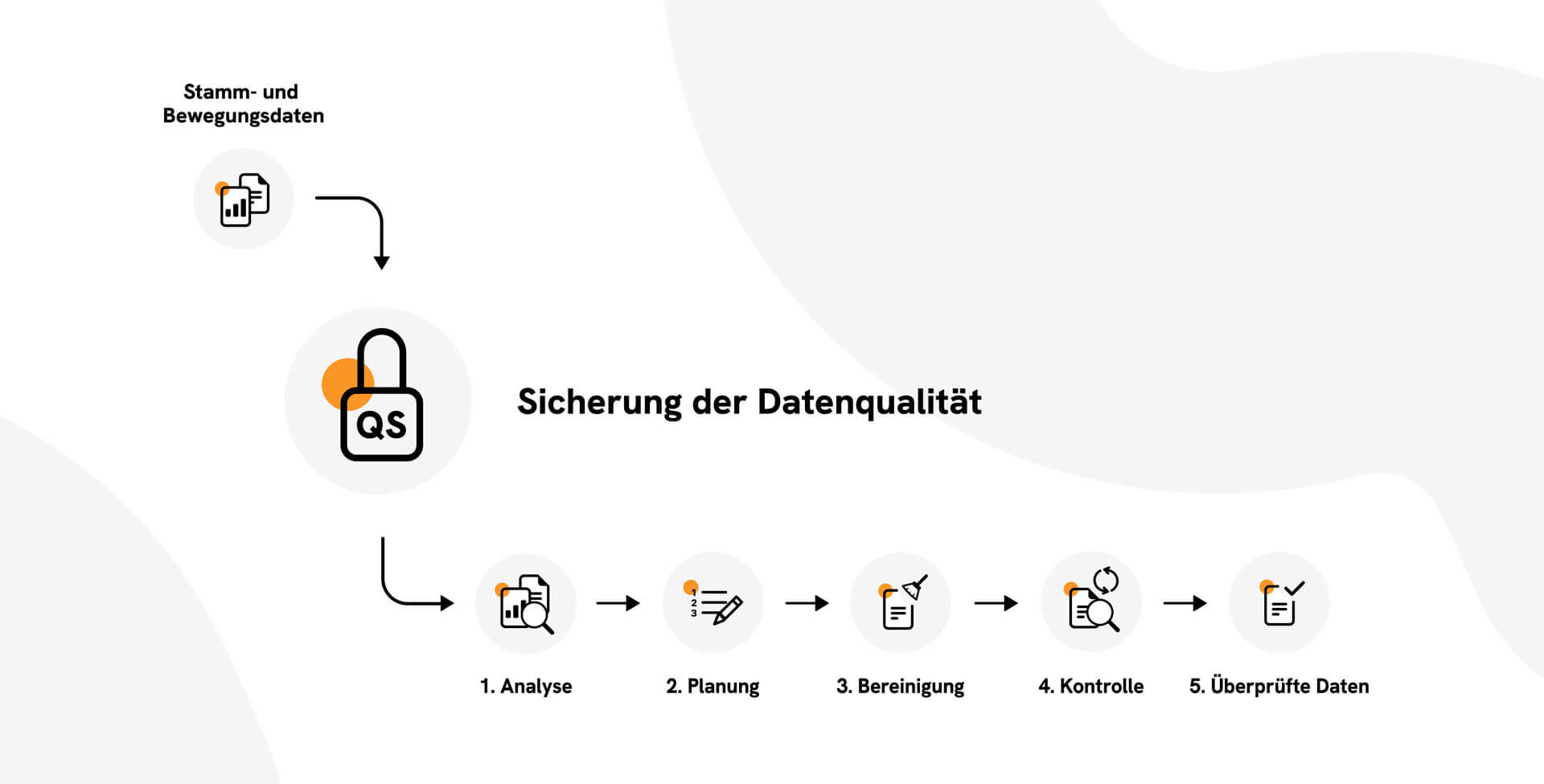

Mit unserem Ansatz des kontinuierlichen Datenqualitätskreislaufes mit ineinandergreifenden Maßnahmen erreichen wir einerseits sehr kurzfristige Effekte zur Behebung von akuten Datenschiefständen und andererseits ein nachhaltiges, hohes Qualitätsniveau der kritischen Unternehmensdaten.

Qualitätssicherung Ihrer Daten: Identifikation und Prävention von Datenfehlern

- In der Analyse-Phase verschaffen wir uns mit (meist schon vorhandenen Analyse-Bordmitteln) einen Überblick über den Zustand der im Fokus stehenden Stamm- und Bewegungsdaten. Dazu werden die erforderlichen Daten aus den verschiedenen Quellsystemen extrahiert und validiert. Damit identifizieren wir die Ursachen für schlechte Datenqualität, z. B. Defizite bei Art und Umfang der Datenerfassung und -verarbeitung, Inkonsistenzen bei Datenattributen, Verstöße gegen vorgegebene Regeln zur Datenerfassung, Schnittstellenbrüche etc.).

- In der Planungsphase erarbeiten wir gemeinsam mit den beteiligten Fachbereichen und der IT kurzfristige Feuerwehr-Maßnahmen, wenn die Gefahr besteht, dass fehlerhafte Daten oder Inkonsistenzen zu Folgefehlern oder zu negativen Außenwirkung für das Unternehmen führen. Zudem beginnen wir mit der Entwicklung eines Konzepts mit mittel- und langfristigen organisatorischen und technischen Maßnahmen zur nachhaltigen Steigerung und Wahrung des Datenqualitätsniveaus. Dieses wird im Verlauf der weiteren Phasen kontinuierlich optimiert.

- In der Bereinigungsphase koordinieren wir die Umsetzung der geplanten und beschlossenen Maßnahmen, die die in der Analyse erkannten Defizite beseitigen und die Qualität der Daten optimieren sollen.

- In der Kontrollphase etablieren wir Prozesse und Quality Gates, die ein kontinuierliches Überwachen und Dokumentieren der Datenqualität im Unternehmen sicherstellen. Scorecards und Cockpits helfen beispielsweise dabei, die Qualität einzelner Datenbestände auf einen Blick zu erfassen und zu beurteilen.

- Die Ergebnisse der Kontrollphase bilden die Grundlage für eine erneute Analyse der Datenqualität und schließen damit den Datenqualitätskreislauf.

Beispielprojekt

2016: Bei einem Energieversorgungsunternehmen wurde im Rahmen eines IT-Programms eine Marktrollentrennung im Sinne des informatorischen Unbundling (Trennung Netz / Vertrieb) hergestellt. Damit verbunden war die Migration von Stamm- und Bewegungsdaten aus dem Altsystem in eine neue SAP® IS-U-Umgebung.

Ein Folgeprojekt umfasste die Analyse und die Herstellung der Prozessierbarkeit von komplexen Datenkonstrukten, die nicht oder nur fehlerhaft in das Zielsystem SAP® IS-U migriert werden konnten. Diese wurden unter „Quarantäne“ gestellt und sollten sukzessive bereinigt werden. Die Bereinigung unterlag strengen Dokumentationsanforderungen, da sie direkt im Produktivsystem erfolgte.

Mit einem Projektteam von zeitweise bis zu 60 SAP® IS-U-Experten übernahmen wir die Planung und Koordination aller Datenbereinigungsaktivitäten.

Unsere Aufgaben im Einzelnen:

- Voranalyse und Klassifizierung nach Fehlerbildern

- Planung und Etablierung von abgestuften Bereinigungsverfahren, Prüfschritten, Quality Gates und Umsetzung eines Sperr- und Entsperrkonzepts

- Organisation der Bereinigungsteams

- Planung und Steuerung des Ressourceneinsatzes

- Priorisierungs- und Eskalationsinstanz

- Fachlicher Ansprechpartner für die Fachbereiche

- Berichtswesen und Projektkommunikation

- Stakeholdermanagement

Aufgrund der sich permanent verändernden Rahmenbedingungen wählten wir zur Organisation der Aufgaben und Teams agile Methoden (KANBAN, Timeboxing, Retrospektiven, Visualisierung des Workflows und des Bearbeitungsfortschritts) und konnten damit schnell und flexibel reagieren und die Eigenverantwortung der Teams für Qualität und Tempo der Bereinigung stärken.

Die Datenbereinigung von mehreren Tausend komplexen Datenkonstrukten mit einer Vielzahl von abhängigen Stamm- und Bewegungsdaten erstreckte sich über einen Zeitraum von zehn Monaten. Ausdauer, Präzision und Sorgfalt wurden auf eine harte Probe gestellt, doch letztlich waren sie ausschlaggebend für den nachhaltigen Erfolg. Die geringe Anzahl an Rückläufern und der mit zunehmender Projektdauer kontinuierlich steigende Output bestätigten das systematische und gleichzeitig agile Vorgehen.